Si Google a indexé des pages qui sont bloquées par robots.txt, cela ne pose généralement pas de problème.

Les pages qui sont bloquées par robots.txt peuvent également figurer dans l’index Google. Cela peut par exemple se produire lorsqu’une page déjà indexée est bloquée ultérieurement par robots.txt, de sorte que Google ne peut plus l’explorer. Dans un tel cas, Google ne serait même pas en mesure de reconnaître un « nofollow » présent sur la page. Les liens externes vers une page bloquée par robots.txt peuvent également entraîner l’indexation de la page.

Pas un problème pour Google

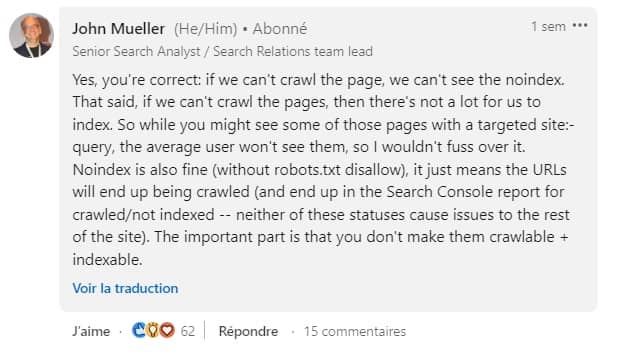

Pour la recherche Google, ce n’est toutefois pas un problème si des pages bloquées par robots.txt sont indexées. C’est ce qu’a expliqué John Mueller sur LinkedIn. Il a commenté le post d’un utilisateur qui a fait état d’une technique de spam particulière. Celle-ci consiste à créer des backlinks sur des pages de résultats de recherche internes inexistantes de sites web. Et bien que les URL correspondantes soient bloquées par robots.txt, elles ont été indexées par Google.

Mueller a écrit que si Google ne pouvait pas explorer une page, le « noindex » ne pouvait pas non plus être détecté. Et si l’on peut trouver des pages bloquées par robots.txt à l’aide d’une recherche « site : », on ne devrait pas s’en inquiéter. En ce qui concerne le cas de la technique de spam décrite, Mueller a écrit qu’un blocage par robots.txt et un « noindex » étaient tous deux corrects. Les deux conduisent à des statuts différents dans la Search Console et les deux ne posent pas de problème pour le reste du site web. Il faut juste veiller à ce que les pages non souhaitées ne soient pas à la fois crawlables et indexables :

Il est recommandé d’opter pour une variante. Dans un souci d’efficacité, il peut être avantageux de miser sur un blocage via robots.txt. Google n’a alors pas besoin d’explorer les pages. Cela permet d’économiser des ressources pour Google, et aussi pour le serveur web du site web.

0 commentaires